流量密碼 提供 科技、娛樂、流行、穿搭、影劇、遊戲、電競、開箱、資訊、正妹網紅女神 等各類新聞資訊等,發燒話題永不退流行,讓您第一手快速掌握,快速更新文章及最新消息的發布就是我們的宗旨,只要隨時關注流量密碼資訊就是掌握 流量密碼。

ChatGPT、Bloom、LLaMA、Bard等大型語言模型LLM現在已經可以回答問題、生成文章、提供推薦、翻譯語言,甚至在某些情況下,協助醫生找到病因。但是這些大型語言模型有時還是會出現胡言亂語或者給於錯誤資訊的問題。大家使用LLM的時候不能百分之百的相信LLM給於的答案,還是需要再確認內容的正確性。近日,Discord的Bard社群裡Bard的資深產品經理Dominik Rabiej表示他對大型語言模型所生成的答案保持懷疑態度並推薦大家只有在進行創意和頭腦風暴的時候再使用Bard。

連Google的內部人員都認為Bard給的答案不要盡信,使用內容前要先查證

近日,Discord的Bard社群裡有兩位成員透露了Bard社群在7月至10月期間的聊天室內容給bloomberg。在聊天室的內容裡,Bard的資深產品經理Dominik Rabiej表示,他對大語言模型生成的答案持懷疑態度,並建議人們只在進行創意和頭腦風暴時使用Bard。再者,也可以將Bard應用於編輯程式,因為使用者總是需要檢查代碼的正確性。

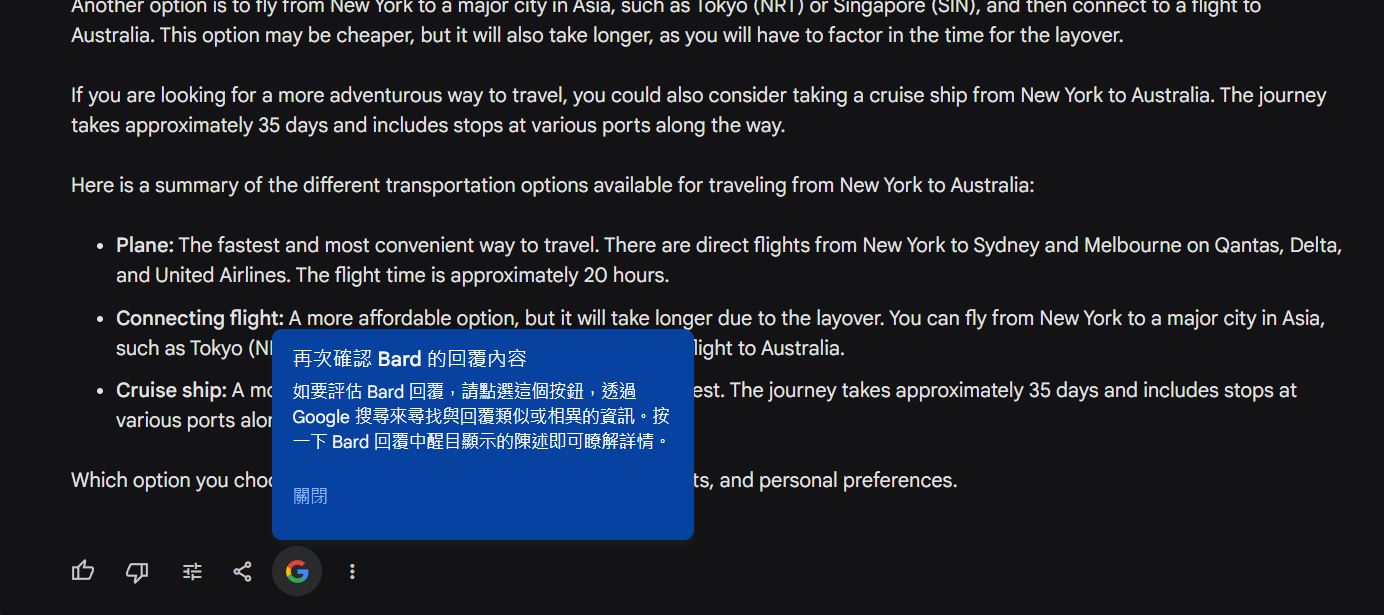

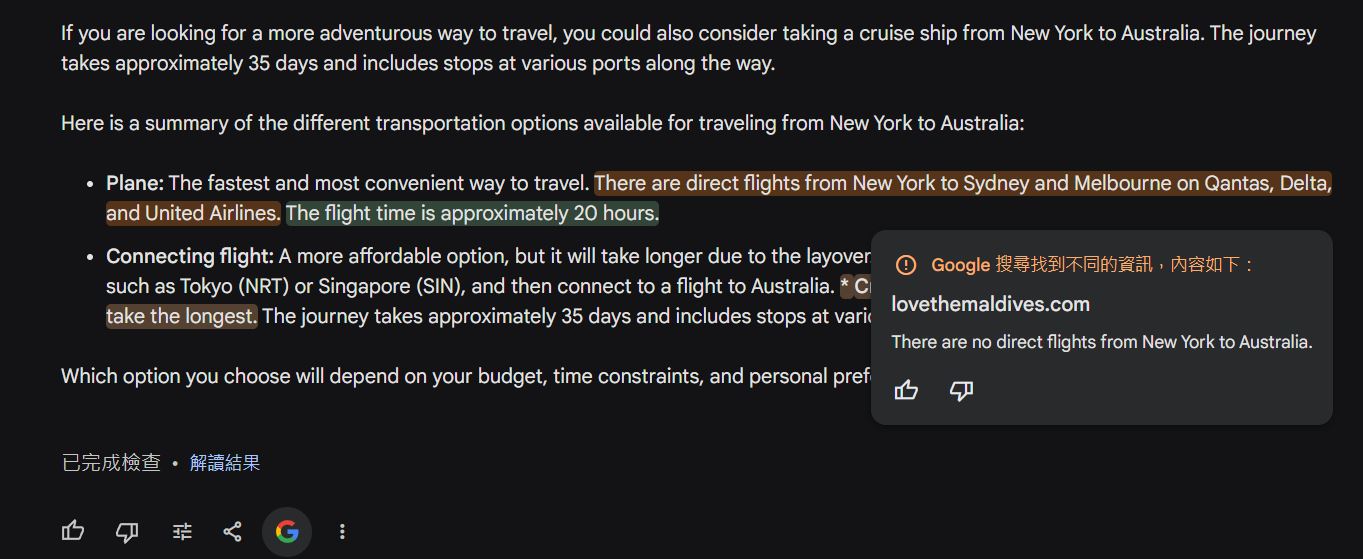

Rabiej也強調Bard並不真正理解它所獲取的文本,只是基於用戶給的提示生成更多的文本回覆。雖然Bard有再次確認回覆內容功能可以用橘色突出可能有錯誤的內容。但是Bard和其他大型語言模型一樣都是在生成文本,並不是在幫助用戶找資料或進行總結。所以Rabiej在7月的一次聊天中明確表示除非使用者可以獨立驗證,不然不要盲目信任大型語言模型輸出的結果。

另一名產品經理Warkentin也在聊天中表示,要讓Bard適合所有人的話,Bard必須改進的更人性化。他認為如果用戶無法評估Bard的功能,那將會產生一個巨大的錯誤。Warkentin更強調:我們需要的不是只為少數人服務的產品,而是能夠惠及所有人的產品。

大家在使用大型語言模型的時候,自己還是需要確認接收到的答案是否正確,不要LLM給你什麼你就照單全收。小編覺得Bard的資深產品經理所講是所有大型語言模型都會發生的問題,ChatGPT、Bloom、LLaMA、Bard等大型語言模型都是生成式的,大部分時間給予我們的答案可能都很正常,像是之前寫過ChatGPT 幫助罕病兒找出病因的事件。但是有時也會發生產生誤判的問題,所以得到答案之後還是要自己再檢查才不會發生使用錯誤訊息的問題。

SOURCE