流量密碼 提供 科技、娛樂、流行、穿搭、影劇、遊戲、電競、開箱、資訊、正妹網紅女神 等各類新聞資訊等,發燒話題永不退流行,讓您第一手快速掌握,快速更新文章及最新消息的發布就是我們的宗旨,只要隨時關注流量密碼資訊就是掌握 流量密碼。

完全沒有錯過生成式 AI 的潮流,甚至比起與 OpenAI 走得超近的微軟可能都還要更為積極打造最有效率、最友善 ChatGPT 的瀏覽器的 Opera(看更多:Opera 應該是使用 ChatGPT 最有效率、最友善的瀏覽器,這篇告訴你為什麼)。近日進一步利用三方瀏覽器相對自由的特性,重磅宣布將成為全球首款內建安裝使用本地 AI 模型的主流瀏覽器。繼續閱讀瀏覽器直接在本地裝 Gemma 與 Llama AI 用!Opera 成史上第一人(器?)報導內文。

▲本篇圖片來源:Opera

瀏覽器直接在本地裝 Gemma 與 Llama AI 用!Opera 成史上第一人(器?)

其實本來瀏覽器(Browser)也不一定要連網才有用處。但相對於以往除了用來讀取離線網頁、NAS 路由器的頁面等,總覺得大部分瀏覽器應該還是偏向於連網來獲取即時的資訊與應用用途居多。

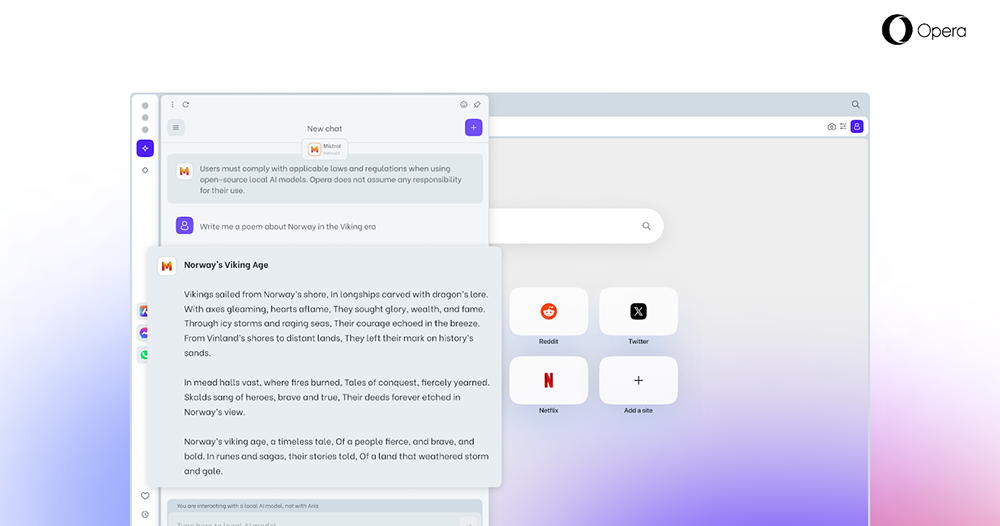

這次 Opera 算是善用自己三方瀏覽器的優勢,宣告將成為目前主流瀏覽器中少數直接支援 150 個瞄準本地安裝使用的 LLM 大型語言模型如:Meta Llama 、Vicuna、Google Gemma 與 Mistral AI Mixtral 等各種模型。直接透過在 Opera 瀏覽器所內建的介面管理使用這些模型,讓瀏覽器離線使用的用處大大提升。

目前來說,要在電腦的本地端安裝大型語言模型聊天機器人的模型其實已經沒想像中的困難。電腦王阿達團隊也已經有在 Windows 甚至是 Mac 電腦上安裝的教學(看更多:教你在電腦裡安裝 Google Gemma AI 模型,無需網路就能運行)。

這樣的使用方式,除了可以獲得不再需要等候網路與系統可能有所延遲的反應緩慢狀況,可以更快速更有效率的取得分析的成果外。另一方面,對於許多公司行號而言,能夠全然的在本地端執行這些模型,也能避免早期生成式 AI 把個人或公司的敏感機密資訊,拿去學習甚至可能導致洩漏到網路上的資安問題發生。

針對這項功能官方已經開始針對 Opera One Developer 開發者版本提供這項實驗功能的測試。

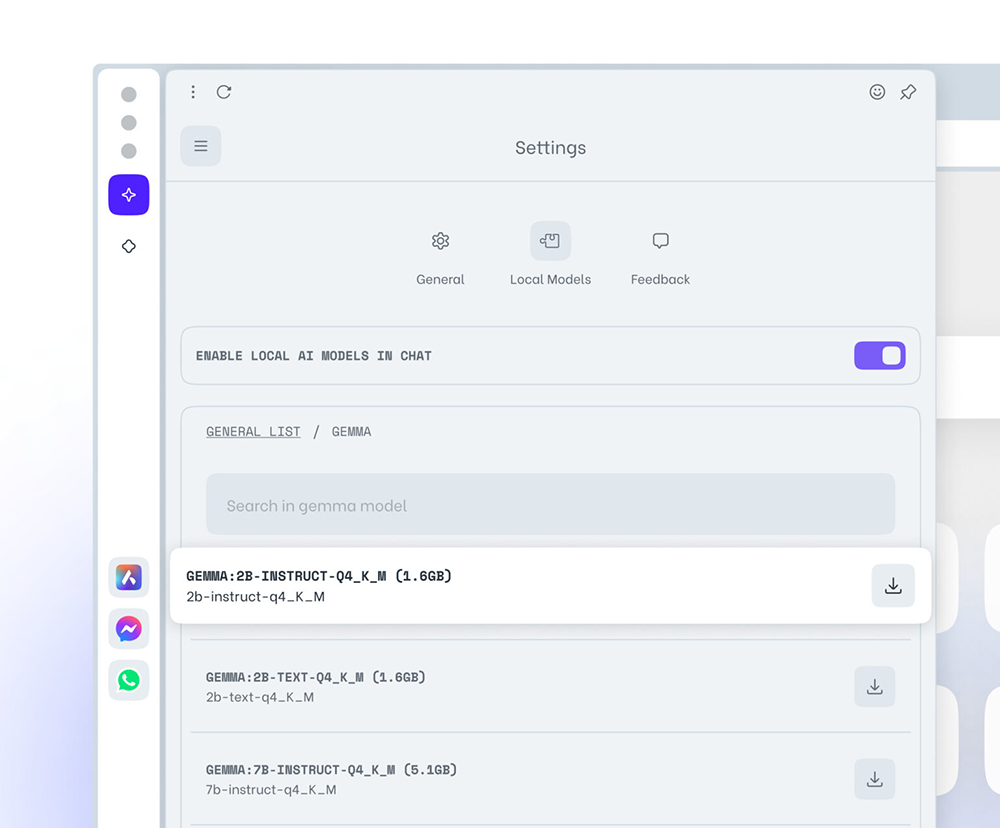

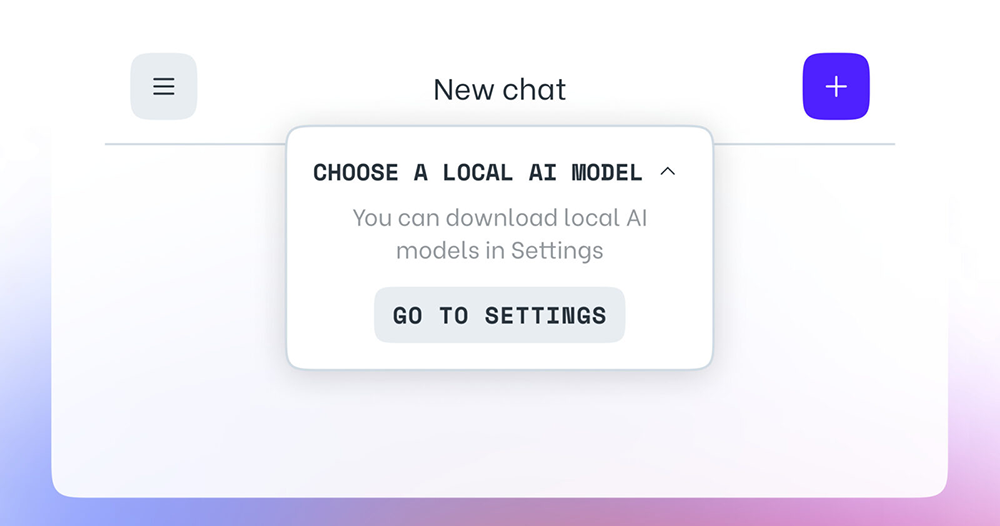

使用方法非常簡單!安裝的話,只需要開啟瀏覽器左側的 Aria Chat 側邊欄功能 – ChatGPT 也能在這個「AI Services」的側邊欄位找到。接著進入 Aria Chat 中,選擇「Local Models(本地模型)」即可找到選擇像是 GEMMA:2B-INSTRUCT-Q4_K_M 等模型的相關功能。

這裡最棒的是,Opera 直接就提供你下載的選項,所以你也不用自己到處找這些資源,就可以非常輕易的上手安裝這些大型語言模型來使用了。唯一比較麻煩的,可能就是要注意一下電腦上的儲存空間是否足夠 – 官方建議是至少要有約 2~10GB 左右。選擇本地端的 LLM 模型之後,你針對 Opera 內建的 Aria AI 所進行的聊天內容,都將會改採本地端的模型來進行處理。

沒意外(沒出什麼大問題)的話,Opera 應該會將此功能在未來的正式版本納入 AI Feature Drops 中。感覺也可以期待未來三方瀏覽器都將會跟上這樣的本地端 AI 功能。

引用來源|經由|Opera 下載

延伸閱讀:

Google 搜尋助你當柯南,新工具幫你挖出網頁/圖片滿滿歷史與資訊